Amikor repülés közben szerelik a repülőt: a ChatGPT meghibásodásai szinte mindennaposak – megoldás még nincs, csak kapkodó fejlesztések

Az elmúlt hónapokban a mesterséges intelligencia (MI) fejlődése újabb látványos fejezethez érkezett, de ezúttal nem feltétlenül a diadalról szólt. Miközben az OpenAI a világ legnépszerűbb MI-fejlesztőjévé nőtte ki magát, a felhasználók egyre gyakrabban tapasztalják a gépezet akadozását. A cég hivatalos szerverállapot-oldala szerint július óta a napok közel 80 százalékában fordult elő valamilyen fennakadás, részleges vagy teljes szolgáltatásleállás, tehát a ChatGPT meghibásodása szinte mindennapos. Egy olyan rendszer esetében, melyet ma újságírók, kutatók, fejlesztők, tanárok és diákok milliói használnak, ez már nem csupán technikai kellemetlenség, hanem jelzésértékű tünet.

A mesterséges intelligencia háttérrendszerei rendkívül összetettek: az OpenAI szolgáltatásai is számos mikroszolgáltatásból, adatbázisból és kommunikációs rétegből állnak. A cég az utóbbi hónapokban egyre agresszívabban fejleszt, új funkciókat és modelleket vezet be – ilyen volt például

- a GPT-5 előzetes verziója,

- a továbbfejlesztett DALL-E képgenerátor,

- a hangalapú interakciók

- vagy a memóriamodul.

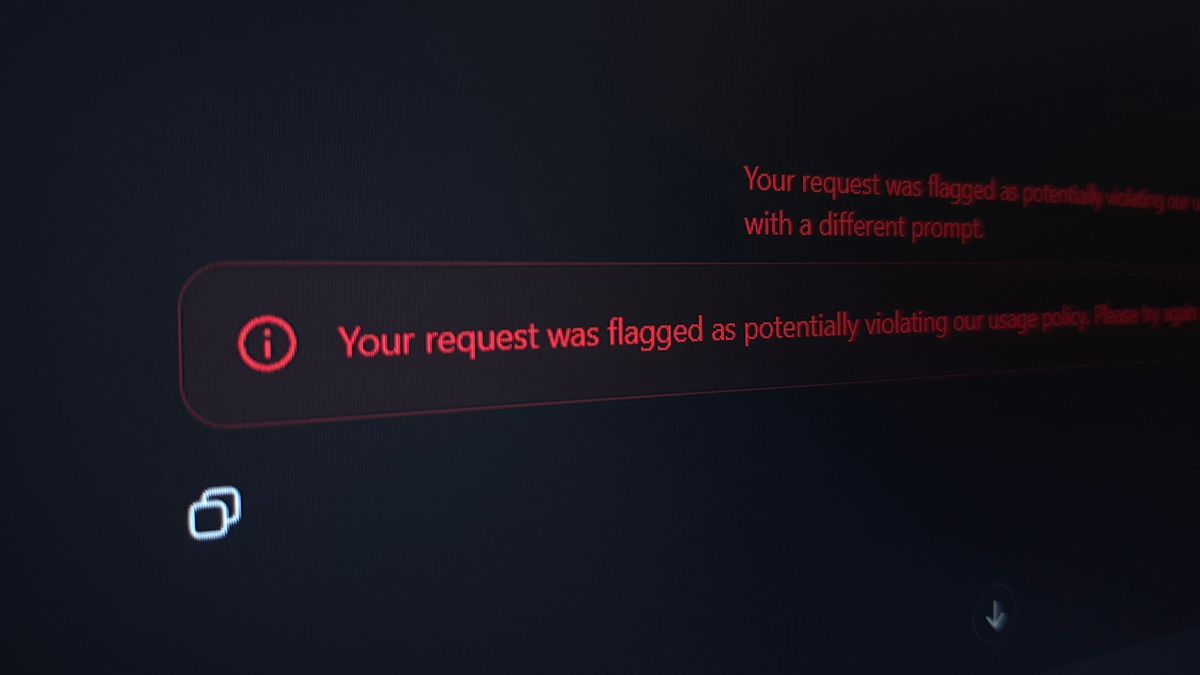

Ezek azonban nem külön rendszerek, hanem egymással szorosan összekapcsolt elemek: ha egyetlen fogaskerék megakad – például a képfeldolgozó modul –, az egész gépezet belassulhat. A felhasználó ilyenkor azt látja: nem tölt be a cset, nem generál képet, vagy épp „hiba történt” felirat jelenik meg. A szerverállapot-oldalon mindez sárga vagy piros figyelmeztetésként bukkan fel, és egy pillanat alatt több millió ember munkáját szakíthatja félbe.

Mi okozhatja a ChatGPT meghibásodásait?

A probléma gyökere részben a fejlesztési tempóban keresendő. Az OpenAI a tavalyi év végén még havi frissítésekkel dolgozott, idén nyárra azonban heti rendszerességgel kezdte élesíteni a modellverziókat. Minden új modellhez új háttérszolgáltatás, új adatfeldolgozó réteg, új hitelesítési modul társul. Ezeket a frissítéseket gyakran menet közben hajtják végre, vagyis miközben a rendszer teljes gőzzel fut, a háttérben kódot, adatbázist és konfigurációt cserélnek. Ez a módszer gyors, de kockázatos: elég egy hibás beállítás, és percek alatt globális leállás következhet be.

A július 15-i konfigurációs hiba például kevesebb mint tíz sor kódra vezethető vissza, mégis csaknem egyórás kiesést okozott világszerte.

A másik nagy tényező az infrastruktúra. Az OpenAI a Microsoft Azure felhőjén működik, mely bár megbízható, nem sérthetetlen. Ha az Azure egyik régiójában – például Észak-Amerikában – hálózati hiba vagy DNS-zavar lép fel, az pillanatok alatt kihat az OpenAI teljes rendszerére. A felhasználó ezt nem látja, csak annyit érzékel, hogy a modell „nem válaszol”. Ilyenkor gyakori, hogy a szolgáltatás nem áll le teljesen, csupán lassul vagy ideiglenesen korlátozott – a status oldalon viszont ez is hibának minősül, így újabb sárga csík jelenik meg a grafikonon.

A probléma valójában mi vagyunk

A harmadik ok az emberek, pontosabban a felhasználók tömege. Az OpenAI becslések szerint kétszázmillió aktív ChatGPT-használót szolgál ki, és több millió előfizetőt. A rendszer nem tud mindenkit egyszerre kiszolgálni, ezért úgynevezett prioritási sorokat alkalmaz. A fizetős felhasználók előnyt élveznek, az ingyenesek gyakrabban kapnak hibaüzenetet.

Amikor a világ különböző régióiban egyszerre emelkedik meg a terhelés, a rendszer szándékosan „megvonja” a hozzáférést bizonyos moduloktól, hogy elkerülje a teljes összeomlást.

Ilyen terhelés lehet, amikor Európában kora este megrohamozzák a ChatGPT-t, miközben az Egyesült Államokban munkaidő van. Ezeket a torlódásokat szintén hibaként jelzi a rendszer, hiszen az elérhetőség csökken, még ha nem is globális leállásról van szó.

A felelősség tehát több szereplő között oszlik meg, de a hibák többsége egyértelműen az OpenAI oldalán keletkezik: rosszul időzített frissítések, elégtelen előtesztelés, valamint az új modulok közti túlzott függés okozza őket. Az Azure-hibák ritkábban fordulnak elő, és jellemzően rövidebbek, de mivel a szolgáltatás a Microsoft-felhőre épül, ezek ellen az OpenAI gyakorlatilag védtelen.

Van egy egyszerű megoldás, csak dollármilliárdok kellenek hozzá

A javulás elméletileg lehetséges. Az iparági szabvány szerint a 99,9 százalékos rendelkezésre állás lenne az elfogadható minimum – ez napi 1,5 perces átlagos kiesést engedne. A mostani nagyjából 80 százalékos hibaarány ehhez képest súlyos figyelmeztetés. Javítani csak átfogó architekturális átalakítással lehet: a mikroszolgáltatások elkülönítésével, a régiók közti redundanciával, valamint azzal, ha a frissítéseket nem egyszerre, hanem fokozatosan vezetik be.

Egy stabilabb európai adatközpont-hálózat is csökkentené a kockázatot, hiszen a legtöbb hiba ma is az amerikai régióból gyűrűzik tovább.

Ez viszont egy szinte példátlan európai beruházást, sőt beruházássorozatot jelentene, ami bár nagy lehetőség lenne a helyi vállalkozóknak, de olyan együttműködési hálóra lenne szükség, amire – úgy néz ki – sem az OpenAI, sem a Microsoft egyelőre nem nyitott.

Kiszolgáltatott felhasználók és kapkodó fejlesztések

A felhasználók eközben legfeljebb alkalmazkodni tudnak. Érdemes rendszeresen menteni a fontos beszélgetéseket, ellenőrizni az állapotoldalt, kerülni a csúcsidőt, és nem árt, ha van B terv is. A mesterséges intelligencia ma már nem luxus, hanem munkaeszköz: újságírók, tanárok, kutatók és fejlesztők mindennapi rutinjának része. Éppen ezért nem mindegy, hogy a digitális segéd mennyire kiszámítható. A felhasználó legfeljebb annyit tehet, hogy ment, exportál, és ha kell, más szolgáltatásra vált – de ez nem oldja meg a gyökeret: az MI-világ új függősége a stabil internet-infrastruktúra mellett maga a szolgáltató lett.

Az OpenAI esetében mostanra kialakult egy paradoxon. Miközben a cég a mesterséges intelligencia fejlődésének zászlóshajója, fennmaradását a fejlődés gyors tempója veszélyezteti.

A túl gyors fejlesztés, a versenynyomás és a befektetői elvárások egy olyan környezetet hoztak létre, ahol a stabilitás másodlagos lett a látványos újdonságok mögött.

Az új funkciók marketingértéke hatalmas, de mindegyik újabb rést üt a rendszer kiszámíthatóságán.

A helyzet iróniája, hogy maga a technológia, melyet az OpenAI képvisel, pontosan az ilyen rendszerszintű hibák megelőzésére is alkalmas lehetne. Egy jól betanított, hibafelismerésre és előrejelzésre képes MI-rendszer már percekkel a leállások előtt észlelhetné a torlódásokat, jelezhetné a hálózati torzulásokat, vagy automatikusan korlátozhatná az erőforrásokat. Ehelyett a fejlesztés fókusza máshol van: a látványos kimeneteken, a „beszélő” és „látó” modelleken, nem pedig a háttérrendszer stabilitásán.

A mesterséges intelligencia ígérete az volt, hogy megbízhatóbbá és hatékonyabbá teszi az emberi munkát. Ehhez képest most az emberi munkának kell alkalmazkodnia a gép bizonytalanságaihoz. A status.openai.com színes grafikonjai mára nem csupán technikai statisztikák – hanem tükör: azt mutatják, milyen törékeny az a rendszer, melyre milliók mindennapja épül. És ha a jövő mesterséges intelligenciája valóban az emberi tudás örököse lesz, akkor először a saját alapjait kell megerősítenie. Mert amíg a gép ennyiszer megakad, addig a forradalom nem halad, csak szaggat.